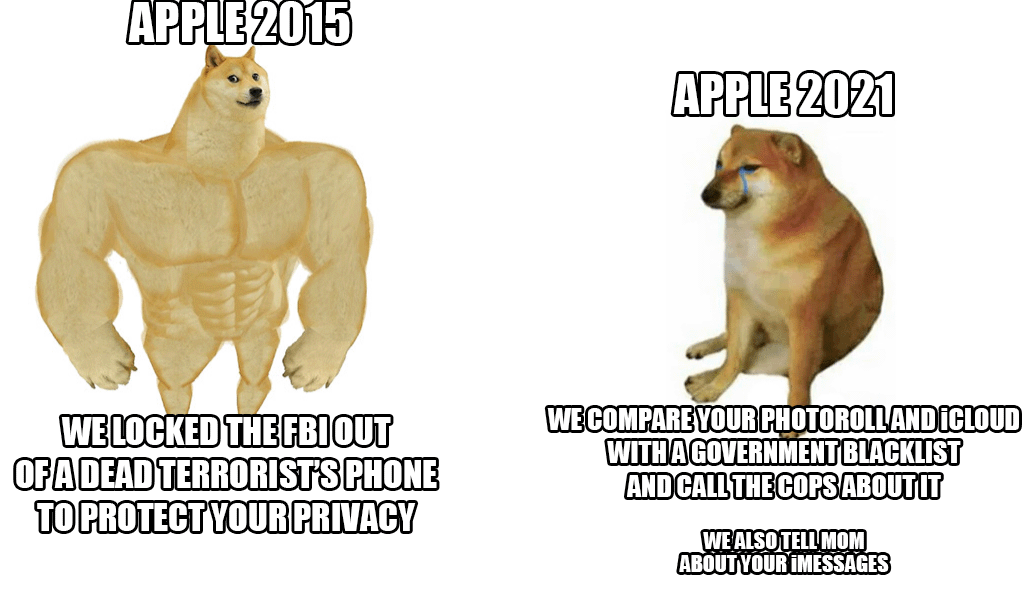

No final da semana passada, a Apple revelou um novo sistema anti-abuso infantil que irá verificar as fotos do iCloud de praticamente todos. Embora a ideia pareça boa à primeira vista, já que as crianças precisam realmente de ser protegidas desta ação, a gigante de Cupertino foi, no entanto, criticada por uma avalanche – não só por parte de utilizadores e especialistas em segurança, mas também por parte dos próprios funcionários.

De acordo com as últimas informações de uma agência respeitada Reuters vários funcionários expressaram suas preocupações sobre este sistema em uma comunicação interna no Slack. Alegadamente, deveriam ter medo de possíveis abusos por parte das autoridades e dos governos, que poderiam abusar destas possibilidades, por exemplo, para censurar pessoas ou grupos seleccionados. A revelação do sistema gerou um forte debate, que já conta com mais de 800 mensagens individuais dentro do citado Slack. Em suma, os funcionários estão preocupados. Até mesmo especialistas em segurança já chamaram a atenção para o facto de que nas mãos erradas seria uma arma realmente perigosa usada para reprimir activistas, a sua mencionada censura e coisas do género.

A boa notícia (até o momento) é que a novidade só começará nos Estados Unidos. Neste momento, nem sequer está claro se o sistema também será utilizado nos estados da União Europeia. Porém, apesar de todas as críticas, a Apple se mantém sozinha e defende o sistema. Ele argumenta acima de tudo que toda a verificação ocorre dentro do aparelho e uma vez que há correspondência, só nesse momento o caso é verificado novamente por um funcionário da Apple. Somente a seu critério será entregue às autoridades competentes.

Poderia ser Interessa você

Eu odiaria mudar do iCloud para algo seguro e verdadeiramente privado, mas se a Apple insistir, deixarei de pagá-los de qualquer maneira.

Estará ativo (por enquanto) apenas nos EUA

Realmente não importa onde será aplicado legislativamente. Essa tecnologia já estará disponível e implantada. Esse é o maior risco.